BigQuery Backup & Disaster Recovery (Automatisierte granulare Wiederherstellung)

Was ist BigQuery?

BigQuery ist ein Data Warehouse auf Unternehmensebene mit einer serverlosen Architektur, die es Nutzern ermöglicht, SQL-ähnliche Abfragen auf großen Datensätzen mit der Rechenleistung der Google-Infrastruktur durchzuführen.

Als vollständig verwaltete Lösung verfügt BigQuery über integrierte Funktionen wie maschinelles Lernen, Business Intelligence, Echtzeit-Analysen und sogar georäumliche Analysen, die modernen Unternehmen helfen, große Datenmengen für ihre Entscheidungsfindung zu nutzen. Das liegt vor allem an seiner Fähigkeit, Terabytes an Daten in Sekunden und Petabytes in Minuten zu verarbeiten, was es zu einem perfekten Tool für die Datenanalyse im großen Stil macht.

Wichtig ist, dass BigQuery serverlos ist. Das bedeutet, dass keine Infrastrukturverwaltung erforderlich ist. Das macht es einfacher, sich auf die Analyse wichtiger Daten zu konzentrieren, um aussagekräftige Erkenntnisse zu gewinnen, anstatt sich um den Overhead zu kümmern.

Bedeutung von BigQuery für Data Analytics und Warehousing

Das Konzept von 'Big Data (Volumen, Geschwindigkeit und Vielfalt) stellt eine große Herausforderung für die Datenverarbeitungsfähigkeiten herkömmlicher Systeme dar. Dies liegt genau an ihrer begrenzten Kapazität, Skalierbarkeit und Verarbeitungsleistung, die es nahezu unmöglich und zeitaufwendig machen, sinnvolle Erkenntnisse aus riesigen und komplexen Datensätzen zu gewinnen.

Glücklicherweise kommt an dieser Stelle BigQuery ins Spiel. Die robuste Architektur von BigQuery ermöglicht es Unternehmen, Modelle für maschinelles Lernen mit strukturierten und halbstrukturierten Daten direkt in BigQuery zu erstellen, zu trainieren und einzusetzen und so den Prozess der Gewinnung von Erkenntnissen zu rationalisieren.

Außerdem nimmt BigQuery aufgrund seiner einzigartigen Vorteile eine wichtige Position ein, wie z.B.:

- Ein serverloses Modell, das zur Vereinfachung der Abläufe beiträgt.

- Seine Hochgeschwindigkeitsfunktionen ermöglichen das Einfügen von Tausenden von Datenzeilen pro Sekunde und damit Analysen in Echtzeit.

- Die zugrundeliegende Infrastruktur gewährleistet eine hohe Verfügbarkeit und erleichtert die automatische Skalierung zur Aufnahme großer Datenmengen.

- Sie sorgt für robuste Datensicherheit und lässt sich nahtlos in andere Tools und Dienste wie Data Studio, Looker und Tableau integrieren.

- Sein 'pay-as-you-go'-Modell macht es Unternehmen außerdem leicht, Kapazitäten und CAPEX-Kosten zu verwalten - vor allem bei der Infrastruktur, wie Servern, Rechenzentren und anderer Hardware.

Die Notwendigkeit von BigQuery Backup & Restore

Trotz all seiner leistungsstarken Funktionen und Möglichkeiten sind die Daten in BigQuery wie alle anderen 'digitalen Daten' anfällig für versehentliches Löschen, Verlust oder Beschädigung.

Real-World-Beispiel für BigQuery-Datenverlust

Angenommen, ein Unternehmen nutzt BigQuery für seine Data Warehousing-Anforderungen.

- Sie speichern eine Fülle von Daten, darunter Verkaufsdaten, Kundeninformationen und Produktdetails.

- Ein Mitarbeiter könnte eines Tages damit beauftragt werden, veraltete Datensätze aus dem System zu löschen, um die Speichereffizienz aufrechtzuerhalten.

- So führt er einen Befehl aus, der Daten entfernen soll, die älter als fünf Jahre sind.

Aufgrund eines Fehlers im SQL-Befehl interpretiert das System das Löschkriterium jedoch falsch und alle Datensätze, die älter als ein Jahr sind, werden entfernt.

Wenn die Löschung unbemerkt bleibt und ein anderer Mitarbeiter versucht, eine mehrjährige Trendanalyse durchzuführen, wäre das unmöglich, weil ein ganzes Jahr an Daten fehlt. Ohne eine solide Backup-Strategie ist die Wiederherstellung dieser Daten nicht gewährleistet.

In diesem Szenario waren die Daten in BigQuery trotz ihrer Zuverlässigkeit anfällig für menschliches Versagen - in diesem Fall für versehentliches Löschen. Dies kann auch in Szenarien zutreffen, in denen es um die Einhaltung gesetzlicher Vorschriften und die Aufbewahrung von Daten in einigen Unternehmen geht.

Um Ihre wertvollen Informationen zu schützen, ist es wichtig, eine robuste Backup-Strategie zu haben, die sicherstellt, dass Sie sich schnell von unvorhergesehenen datenbezogenen Problemen erholen und die Geschäftskontinuität aufrechterhalten können.

Verwendung von HYCU für Google BigQuery Backup

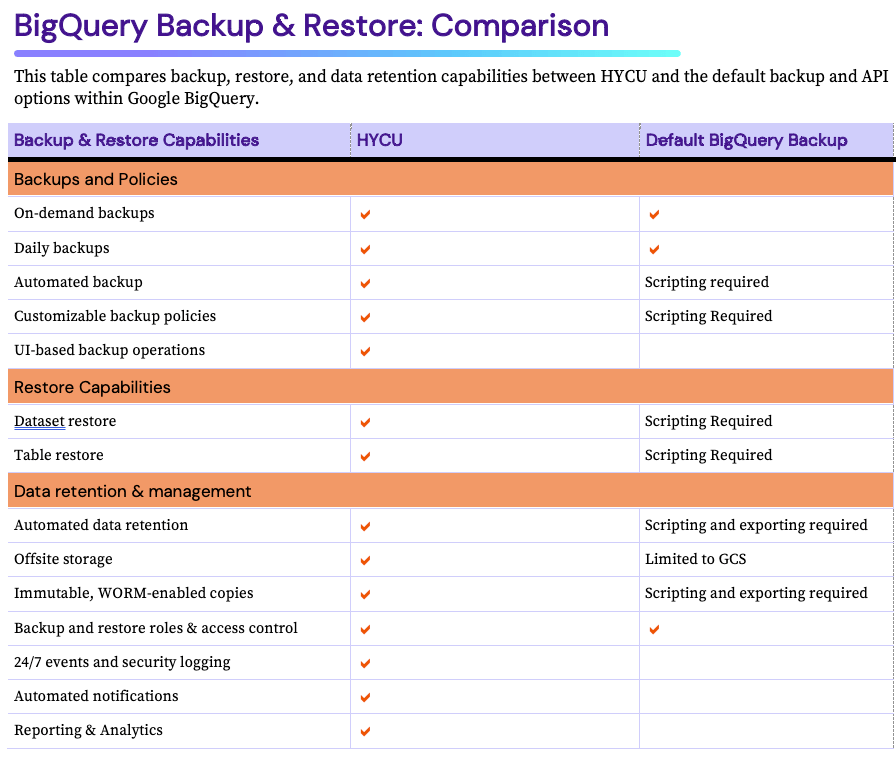

Wenn es um den Schutz Ihrer Daten in Google BigQuery geht, bietet HYCU eine umfassende und einfach zu verwendende Lösung.

- Im Falle eines Datenverlusts oder Systemausfalls ermöglicht HYCU eine sofortige Wiederherstellung Ihrer Tabellen und des vorherigen Zustands. Auf diese Weise gibt es nur minimale Ausfallzeiten und Geschäftsunterbrechungen.

- Ein weiterer Vorteil und eine besondere Stärke von HYCU ist der genaue und zuverlässige Wiederherstellungsprozess für Google Cloud. HYCU stellt sicher, dass die wiederhergestellten Daten ihre Integrität und Konsistenz beibehalten und spiegelt den Zustand der Daten zum Zeitpunkt der Sicherung wider. Dies ist besonders wichtig für analytische oder komplexe Arbeitslasten auf BigQuery, wo Datengenauigkeit und -konsistenz von größter Bedeutung sind.

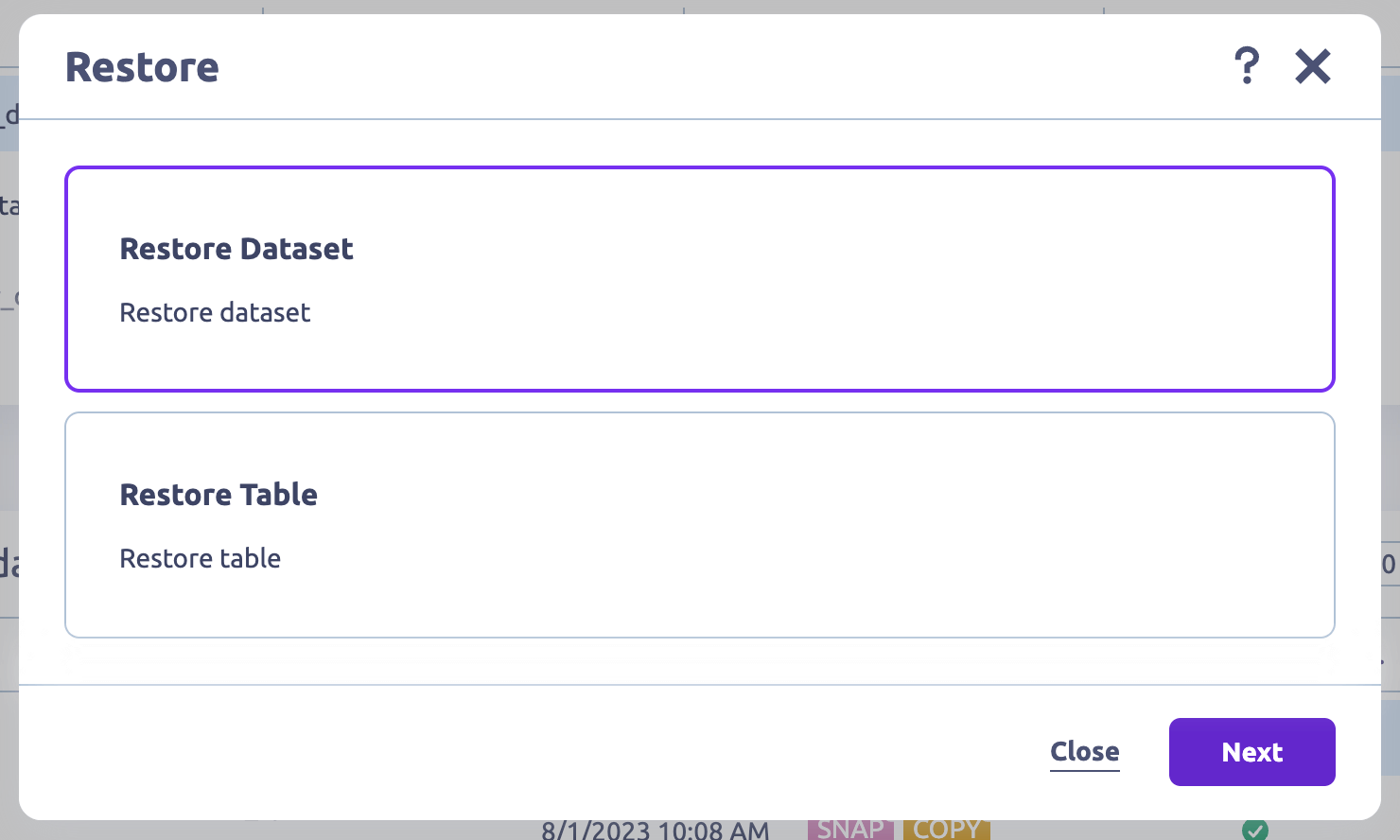

Wiederherstellung von Tabellen und Datensätzen mit wenigen Klicks

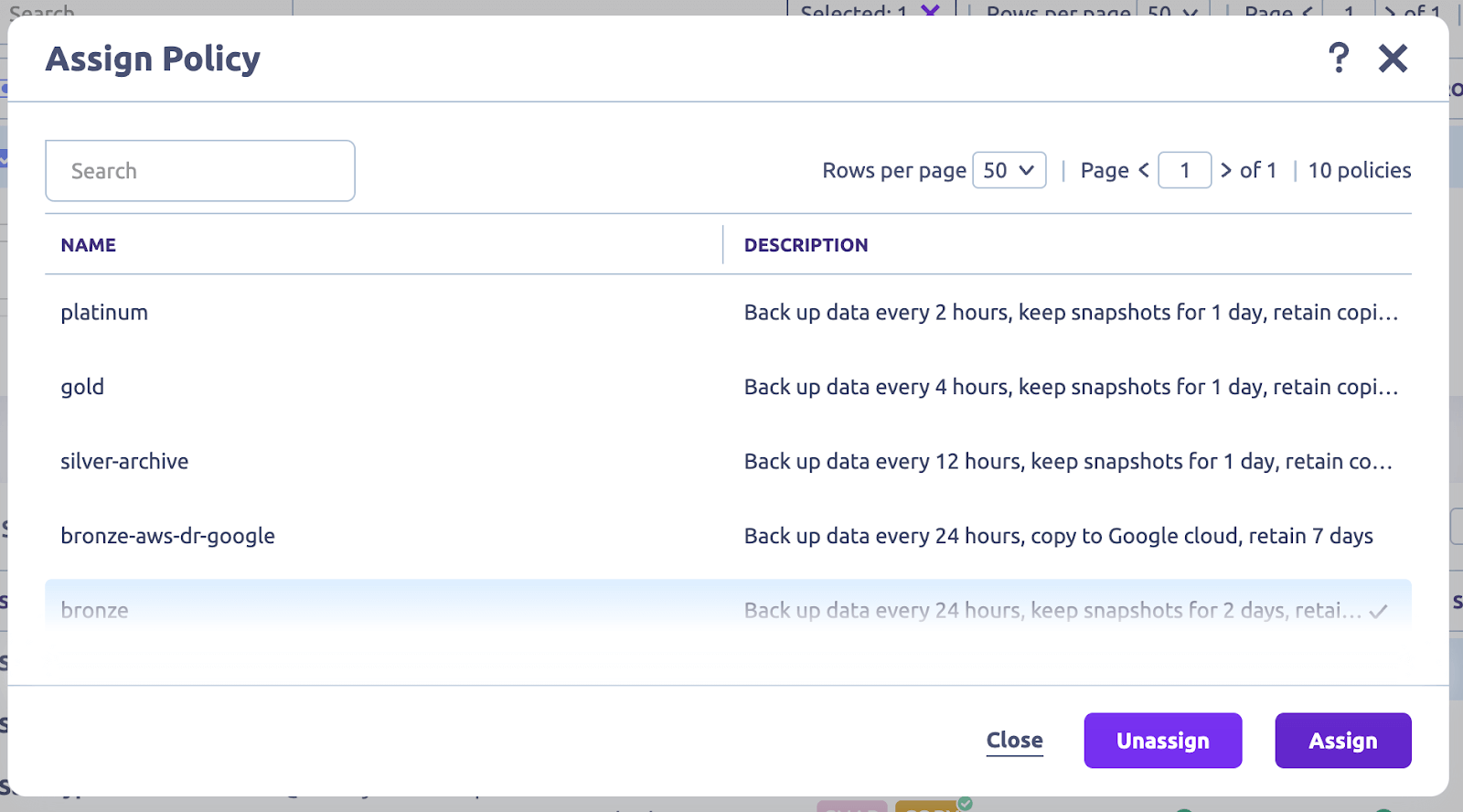

Automatisieren Sie alle Sicherungsvorgänge mit 1 Klick

HYCU automatisiert die Sicherung Ihrer BigQuery-Datensätze, -Tabellen und -Schemata, so dass Sie nicht mehr manuell eingreifen müssen. Dadurch gewinnen Sie Zeit und das Risiko menschlicher Fehler (z.B. versehentliches Löschen per Maus), die zu Datenverlusten führen können, wird drastisch reduziert.

Außerdem bietet HYCU die Möglichkeit, die Backup-Einstellungen anzupassen:

- Planen Sie Backups für Zeiten außerhalb der Spitzenzeiten, um die Auswirkungen auf die Leistung zu minimieren.

- Legen Sie Aufbewahrungsrichtlinien für die Einhaltung gesetzlicher Vorschriften fest.

- Wählen Sie Speicherorte für Backups, um die Datensouveränität zu gewährleisten.

Und alle diese Backups werden während der Übertragung und im Ruhezustand verschlüsselt, um die Sicherheit Ihrer Daten zu gewährleisten.

Computerfreie, native Google Cloud Backups

HYCU ist von Haus aus für die Arbeit mit Google-APIs ausgelegt, und Kunden müssen kein Skript verwenden, um Konfigurationen für herkömmliche Backup-Vorgänge vorzunehmen.

Zusätzlich können Sie HYCU so konfigurieren, dass Ihre BigQuery-Daten auf Google Cloud Storage (GCS) gesichert werden, um sie langfristig aufzubewahren. Diese Flexibilität stellt sicher, dass Ihre gesicherten Daten je nach Ihren spezifischen Anwendungsfällen oder Anforderungen problemlos genutzt oder migriert werden können.

Über BigQuery hinaus: Schützen Sie Ihre Google Cloud-Infrastruktur

HYCU bietet automatisierte Backups und granulare Wiederherstellung über die Google Cloud-Infrastruktur, DBaaS, PaaS und SaaS. HYCU verfügt über die umfassendste Abdeckung der Google Cloud-Infrastruktur und -Services mit vollständiger Unterstützung für:

- Google Cloud Engine (GCE)

- Google Cloud Storage

- Google CloudSQL

- Google BigQuery

- Google Kubernetes Engine (GKE)

- Google Cloud VMware Engine

- Google Workspace

- SAP HANA in Google Cloud

Schützen Sie Ihre Multi-Cloud-Infrastruktur, PaaS, DBaaS und SaaS

HYCU ist nicht auf die Sicherung Ihrer BigQuery-Daten beschränkt; es unterstützt auch verschiedene Datenquellen und Workloads. Das heißt, ob Sie andere Workloads in Google, anderen öffentlichen Clouds, lokalen Rechenzentren oder sogar SaaS-, DBaaS- und PaaS-Anwendungen haben - HYCU kann sie nahtlos sichern und wiederherstellen.

Speziell für BigQuery bietet HYCU umfassenden Datenschutz. Dadurch wird sichergestellt, dass alle Ihre BigQuery-Daten, einschließlich einzelner Tabellen und Schemata, wiederhergestellt werden können.

💡 Verwandte → Top 14 SaaS-Backup-Lösungen & Tools für die SaaS-Datensicherung

Melden Sie sich an und schützen Sie sich mit wenigen Klicks

Eine der herausragenden Eigenschaften von HYCU ist seine benutzerfreundliche Oberfläche und die ausführliche Dokumentation, die das Einrichten und Konfigurieren Ihrer BigQuery-Backups zum Kinderspiel machen.

Zum Beispiel vereinfacht HYCU die Backup-Vorgänge, indem es automatisch alle Instanzen und Workloads in Ihrem Konto erkennt und es Ihnen ermöglicht, mit einem Klick vorgefertigte Richtlinien zuzuweisen oder eigene zu erstellen.

Besonders hervorzuheben ist, dass diese Richtlinien "einrichten und vergessen" sind, d.h. sie laufen 24/7/365 ohne manuelle Eingriffe oder tägliches Management.

Verbesserter Datenschutz und Sicherheit

Neben der automatischen Übernahme von Google Cloud IAM (Identity and Access Management) Rollen und Berechtigungen bietet HYCU auch eine rollenbasierte Zugriffskontrolle (RBAC).

Mit dieser Funktion können Sie Zugriffsrechte und Rollen für Sicherungs- und Wiederherstellungsvorgänge definieren. Dies hilft, unbefugten Zugriff zu verhindern und gewährleistet, dass Ihre Datensicherungen sicher und professionell durchgeführt werden.

Diese Integration stellt sicher, dass Sicherungs- und Wiederherstellungsvorgänge nur von autorisierten Benutzern durchgeführt werden.

Kosteneffiziente Preisgestaltung

HYCU bietet flexible Preisgestaltungsmöglichkeiten, so dass Unternehmen jeder Größe von den robusten Backup-Funktionen profitieren. Die Kosten für die Nutzung von HYCU passen sich Ihren spezifischen Bedürfnissen an, wie z.B. der Menge der zu sichernden Daten, der Häufigkeit der Backups und der erforderlichen Aufbewahrungsfrist. Auf diese Weise können Sie den Service auf Ihre Anforderungen zuschneiden und zahlen nur für das, was Sie benötigen.

Ein Blick auf Ihren Google-Bestand mit Schutzstatus

Wenn es Ihrem Unternehmen wie den meisten geht, nutzen Sie möglicherweise sehr viel mehr Google-Dienste zusammen mit anderen öffentlichen Cloud-Diensten und SaaS-Anwendungen. Dies stellt eine große Herausforderung bei der Verfolgung dar, ganz zu schweigen von der Sicherstellung, dass die Daten und die Konfiguration geschützt und für die Wiederherstellung verfügbar sind. Mit R-Graph können HYCU-Benutzer die gesamte Cloud-Infrastruktur, die Dienste, PaaS, DBaaS und SaaS in einer einzigen "Schatzkarten"-Ansicht verfolgen. Sie können verfolgen, welche Dienste geschützt und konform sind und welche geschützt werden müssen.

💡 Verwandte → Google Workspace (G Suite) Backup & Recovery Solution

Standardoptionen und Konfigurationen für BigQuery Backup

Um BigQuery Backup zu aktivieren, benötigen Sie Administratorzugriff mit den folgenden IAM-Rollen, um Datensätze zu verwalten:

- Kopieren eines Datasets (Beta):

- BigQuery Admin (roles/bigquery.admin) auf dem Zielprojekt

- BigQuery Data Viewer (roles/bigquery.dataViewer) auf dem Quelldataset

- BigQuery Data Editor (roles/bigquery.dataEditor) auf dem Zieldataset

- Löschen eines Datasets: BigQuery Data Owner (roles/bigquery.dataOwner) auf dem Projekt

- Wiederherstellen eines gelöschten Datasets: BigQuery Admin (roles/bigquery.admin) auf dem Projekt

Sobald Sie Zugang haben, können Sie die Backup-Konfigurationen und Optionen unten verwalten.

Backups auf Dataset-Ebene kopieren

Ein typisches Dataset in BigQuery ist ein Container auf oberster Ebene, der Ihre Tabellen und Ansichten enthält. Es ist auch eine effektive Möglichkeit, den Zugriff auf Ihre Daten zu organisieren und zu kontrollieren. So können Sie beispielsweise Rohdaten von verarbeiteten Daten oder Daten aus verschiedenen Abteilungen oder Projekten trennen.

Auf der anderen Seite beinhaltet die Konfiguration von Backups auf Datensatzebene die Erstellung und den Export einer Kopie Ihrer Daten an einen bestimmten Ort, z.B. einen Cloud Storage Bucket. Diese Aktion stellt die Verfügbarkeit und Integrität Ihrer Daten sicher, selbst im Falle einer versehentlichen Löschung oder Änderung.

Methoden zur Konfiguration von Backups auf Datensatzebene

Es gibt zwei Methoden zur Konfiguration von Backups auf Datensatzebene: BigQuery API und SQL-Befehle.

Verwendung der BigQuery API

Mit der BigQuery API können Sie den BigQuery Data Transfer Service verwenden, um automatische Datenübertragungen von BigQuery für einen Cloud Storage Bucket zu planen.

- Da die Backups im Google Cloud Storage Bucket gespeichert werden, erstellen Sie einen neuen Bucket unter dem Abschnitt "Storage" in der Cloud Console.

- Gehen Sie zur API-Bibliothek und aktivieren Sie die BigQuery Data Transfer Service API und Cloud Storage API.

- Wählen Sie eine Programmiersprache und installieren Sie die entsprechende Client-Bibliothek für die BigQuery API. Lesen Sie die Dokumentation hier.

- Installieren Sie das Google Cloud SDK. Damit erhalten Sie das notwendige Befehlszeilentool für die Interaktion mit APIs und anderen Google Cloud-Diensten.

- Authentifizieren Sie das SDK mit Ihrem Google Cloud-Konto über die Befehle der gCLI. Damit stellen Sie sicher, dass das SDK in Ihrem Namen zugreifen und Operationen durchführen kann.

- Wenn Sie noch keins haben, erstellen Sie ein neues Dataset.

- Definieren Sie die Konfiguration. Geben Sie Dataset, Projekt, Tabellen-IDs und Cloud Storage Bucket an.

- Exportieren Sie die Daten aus Ihren BigQuery-Tabellen in einen Cloud Storage Bucket, indem Sie eine Anfrage an die API stellen.

Wenn der Vorgang bestätigt ist, stellen Sie sicher, dass sich Ihr BigQuery-Datensatz und Ihr Cloud Storage an der richtigen Stelle befinden, um mögliche Probleme zu vermeiden.

💡Hinweis → Diese BigQuery-Backup-Option ist nur eine Kopie der vorhandenen Daten und keine inkrementelle Sicherung.

Empfehlenswert → Erfahren Sie mehr über Google Cloud APIs

Verwendung von SQL-Befehlen

SQL-Befehle in BigQuery bieten eine weitere Möglichkeit zur Verwaltung und Interaktion mit Datensätzen. Im Zusammenhang mit der Sicherung von Daten ist das nicht ganz möglich - das gilt für alle BigQuery-Backup-Optionen. Stattdessen wird eine neue Tabelle mit vorhandenen Daten erstellt.

Empfohlen → Lesen Sie die Dokumentation von Google zur Erstellung von Datensätzen mit SQL-Befehlen.

💡Anmerkung: Dies ist keine 'Backup'Lösung, sondern Sie erstellen Datensätze an einem anderen Ort.

Abgesehen von der Einrichtung dieser Backup-Konfigurationen in BigQuery gibt es einige wichtige Parameter, die Sie beachten müssen:

- Backup-Häufigkeit. Dies hängt ganz davon ab, wie häufig sich Ihre Daten ändern. Wenn sich Ihre Daten schnell ändern, benötigen Sie möglicherweise tägliche oder stündliche Backups. Wenn das nicht der Fall ist, können Sie die Häufigkeit auf monatlich oder wöchentlich einstellen.

- Aufbewahrungsrichtlinien. Diese sind nicht überall gleich und können auf der Grundlage der Anforderungen Ihres Unternehmens definiert werden, solange sie mit den für Ihre Branche geltenden Datengesetzen übereinstimmen.

- Schemaerhaltung. Dieser wichtige Aspekt der Konfiguration stellt sicher, dass das Schema (oder die Struktur) Ihrer Daten intakt bleibt. Das bedeutet, dass alle Datentypen, Namen, Tabellen und anderen relevanten Informationen auch während der Replikation korrekt sind.

Snapshots auf Tabellenebene

Das Backup auf Tabellenebene in BigQuery ermöglicht es Ihnen, einzelne Tabellen innerhalb eines Datensatzes für das Backup auszuwählen. Dies ist besonders nützlich in Szenarien, in denen nur einige Tabellen im Dataset gesichert werden müssen.

Erstellen von Snapshots für einzelne Tabellen.

Es gibt zwei Standardmethoden zur Erstellung von Snapshots für einzelne Tabellen:

- Sie können den 'bq extract'Befehl über das Befehlszeilentool verwenden ODER

- Sie können die BigQuery API verwenden, um eine Anfrage zu stellen.

Hier ist ein Beispiel:

bq extract 'my_dataset.my_table' gs://my_bucket/my_table_backup

Wo:

- 'my_dataset.my_table'ist die Tabelle, die Sie sichern wollen - und,

- 'gs://my_bucket/my_table_backup'ist der GCS-Speicherort, an dem die Sicherung gespeichert wird.

Beide Methoden exportieren die Tabellendaten als Dateien in dem von Ihnen gewählten Format in den Google Cloud Storage (GCS)-Bucket, was den Import und die Wiederherstellung der Tabelle bei Bedarf erleichtert.

Das GCS ist aufgrund seiner Sicherheit, Zuverlässigkeit und Kosteneffizienz eine bevorzugte Option für die Speicherung Ihrer BigQuery-Tabellensicherungen.

Exportieren Sie Ihre BigQuery-Tabellensicherungen in verschiedenen Formaten.

Sie können Ihre Tabellendaten in den folgenden Formaten exportieren:

- JSON (Javascript Object Notation). Dies ist ein flexibles und für den Menschen lesbares Format, das leichter zu verstehen und zu bearbeiten ist. Es kann jedoch größer (in der Größe) und langsamer als andere Formate sein.

- CSV (Comma-Separated Values). Dies ist ein einfaches und weithin unterstütztes Format für die meisten Szenarien zur Darstellung von Tabellendaten. Allerdings stellt es komplexe Datenstrukturen nicht genau dar.

- Avro ist ein zeilenorientiertes Framework zur Serialisierung von Daten. Durch sein kompaktes Binärformat ist es ideal für die Verarbeitung großer Datensätze geeignet - insbesondere wenn sich das Tabellenschema im Laufe der Zeit ändert. Außerdem können Sie Dateien, die im Avro-Format gespeichert sind, komprimieren, was den Speicherplatz reduziert und die Zeit für die Sicherung/Wiederherstellung verkürzt.

- Parquet (Apache Parquet) ist ein spaltenorientiertes Datenspeicherformat. Es kann auch große Datenmengen verarbeiten und bietet hervorragende Komprimierungsmöglichkeiten. Allerdings kann es bei häufigen Tabellenaktualisierungen einige Einschränkungen aufweisen.

Handhabung von partitionierten BigQuery-Tabellen und inkrementellen Backups

Die Partitionierung von Tabellen in BigQuery ist ein Ansatz zur Verwaltung und Organisation großer Datensätze.

In der Regel sollten Sie ein Backup auf der Grundlage der bestehenden Partitionsstrategie durchführen.

Dazu können Sie entweder:

- die gesamte Tabelle einschließlich aller Partitionen sichern ODER

- oder bestimmte Partitionen sichern.

Es ist jedoch speichereffizienter, nur geänderte oder neu hinzugefügte Partitionen zu exportieren, wenn Sie mit inkrementellen Backups arbeiten.

Wenn Ihre Tabelle beispielsweise nach Datum partitioniert ist, können Sie nur die heutige Partition extrahieren.

Einschränkungen von Snapshots auf Tabellenebene

- Ein Tabellen-Snapshot muss sich in der gleichen Region und unter der gleichen Organisation befinden wie seine Basistabelle.

- Tabellen-Snapshots sind schreibgeschützt. Sie können die Daten in einem Tabellen-Snapshot nicht aktualisieren, es sei denn, Sie erstellen eine Standardtabelle aus dem Snapshot und aktualisieren dann die Daten. Sie können nur die Metadaten eines Tabellen-Snapshots aktualisieren, z.B. die Beschreibung, das Ablaufdatum und die Zugriffsrichtlinien.

- Sie können nur einen Snapshot der Daten einer Tabelle erstellen, wie sie vor sieben Tagen oder später waren, da die Zeitreise auf sieben Tage begrenzt ist.

- Sie können keinen Snapshot einer Ansicht oder einer materialisierten Ansicht erstellen.

- Sie können keinen Snapshot einer externen Tabelle erstellen.

- Sie können eine vorhandene Tabelle oder einen Tabellen-Snapshot nicht überschreiben, wenn Sie einen Tabellen-Snapshot erstellen.

- Wenn Sie einen Snapshot einer Tabelle erstellen, die Daten im schreiboptimierten Speicher (Streaming-Puffer) enthält, werden die Daten im schreiboptimierten Speicher nicht in den Tabellen-Snapshot aufgenommen.

- Wenn Sie einen Snapshot einer Tabelle erstellen, die Daten im Zeitverlauf enthält, werden die Daten im Zeitverlauf nicht in den Tabellen-Snapshot aufgenommen.

- Wenn Sie einen Snapshot einer partitionierten Tabelle erstellen, für die ein Partitionsablaufdatum festgelegt wurde, werden die Informationen zum Partitionsablaufdatum nicht im Snapshot beibehalten. Die 'ge-Snapshot'-Tabelle verwendet stattdessen die Standard-Ablaufzeit der Partition des Zieldatensatzes. Um die Informationen zum Ablauf der Partition beizubehalten, kopieren Sie die Tabelle stattdessen.

- Sie können einen Tabellen-Snapshot nicht kopieren.

Snapshot-basierte Backups

Ein Snapshot in BigQuery ist eine zeitpunktgenaue Kopie der Daten einer Tabelle (der sogenannten Basistabelle). Das bedeutet, dass er den Zustand der Tabelle und ihrer Daten zu einem bestimmten Zeitpunkt erfasst, so dass Sie bei Bedarf von diesem Punkt aus wiederherstellen können.

Einfach ausgedrückt: Es wird ein Bild Ihrer Daten gemacht. Und das kann für Fälle wie Compliance, Audits oder Trendanalysen wertvoll sein, da es einen konsistenten Überblick über die Daten zu einem bestimmten Zeitpunkt bietet.

💡Hinweis → Tabellen-Snapshots sind 'schreibgeschützt', aber Sie können eine Standardtabelle aus einem Snapshot erstellen/wiederherstellen und sie dann ändern.

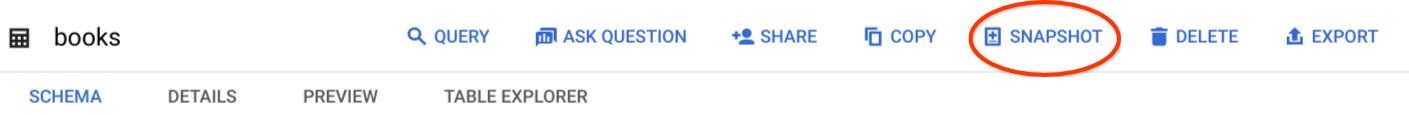

Erstellen und Verwalten von Snapshots für die Point-in-Time-Wiederherstellung

Sie können einen Snapshot einer Tabelle mit den folgenden Optionen erstellen:

- Google Cloud Console

- SQL-Anweisung

- Der

bq cp --snapshotBefehl - jobs.insert API

Wenn Sie beispielsweise die Google Cloud Console verwenden, gehen Sie folgendermaßen vor:

- Gehen Sie zur Cloud Console und navigieren Sie zur BigQuery Seite.

- Suchen Sie den Bereich 'Explorer' und erweitern Sie die Projekt- und Datensatzknoten der Tabelle, die Sie als Snapshot erstellen möchten.

- Klicken Sie auf den Namen der Tabelle und klicken Sie auf 'SNAPSHOT.'

- Als Nächstes würde ein 'Tabellen-Snapshot erstellen' erscheinen. Geben Sie die Informationen Projekt, Tabelle und Datensatz für den neuen Tabellen-Snapshot ein.

- Legen Sie Ihre Ablaufzeit fest.

- Klicken Sie auf Speichern.

Sobald Sie diesen Snapshot erstellt haben, wird er von der Originaltabelle abgekoppelt. Das bedeutet, dass sich Änderungen an der Tabelle nicht mehr auf die Daten des Snapshots in der neuen Tabelle auswirken.

Empfohlen → Erfahren Sie mehr über die Erstellung von Tabellen-Snapshots mit anderen Optionen.

Vorteile von Snapshot-basierten Backups

- Datenversionierung. So können Sie auf die Daten zugreifen, wie sie zu bestimmten Zeitpunkten vorlagen. Auf diese Weise können Sie Änderungen zurückverfolgen oder Daten bei Bedarf in ihren ursprünglichen Zustand zurückversetzen.

- Historische Analyse. Sie können verschiedene Snapshots vergleichen, um Datenänderungen im Laufe der Zeit zu verfolgen. Dies kann Ihnen helfen, Einblicke in Trends zu gewinnen und Ihren Entscheidungsprozess zu verbessern.

- Datenaufbewahrung. Einige Branchen und Unternehmen haben strenge Richtlinien für die Datenaufbewahrung, um die gesetzlichen Vorschriften einzuhalten. Snapshot-basierte Backups ermöglichen es Ihnen, Daten für eine bestimmte Dauer aufzubewahren, wie es die Vorschriften vorschreiben.

Nutzung der BigQuery-Zeitreisefunktion für die Datenwiederherstellung

BigQuery bietet eine Funktion namens 'Zeitreise', mit der Sie auf die historischen Versionen Ihrer Tabelle in den vergangenen sieben Tagen zugreifen können.

Mit der Zeitreisefunktion können Sie die Daten einer Tabelle ab einem bestimmten Zeitpunkt wiederherstellen oder bewahren und alle Änderungen rückgängig machen, die nach dem gewählten Zeitpunkt vorgenommen wurden.

Snapshot-basierte Backups und die Zeitreisefunktion unterstützen Ihre Datensicherungsstrategie in BigQuery erheblich.

Bitte beachten Sie, dass die Zeitreise keine garantierte Wiederherstellungslösung für den Fall eines Betriebsausfalls, eines Cyberangriffs oder einer Naturkatastrophe ist.

Hier ist der Grund dafür:

- Das Zeitfenster für die Wiederherstellung von Daten ist auf sieben Tage begrenzt. Wenn ein Problem innerhalb dieses Zeitrahmens unentdeckt bleibt, können die Daten nicht wiederhergestellt werden.

- Time Travel bietet nicht die Möglichkeit, Ihre Daten zu duplizieren oder zu sichern. Sie ermöglicht es Ihnen lediglich, zu den vorherigen Zuständen Ihrer Daten zurückzukehren.

Daher ist es wichtig, andere Sicherungsmaßnahmen wie regelmäßige Datenexporte zu Google Cloud Storage und Datenreplikation einzusetzen, um eine umfassende Datensicherheit zu gewährleisten.

Implementierung von BigQuery-Backup-Lösungen

Verwendung von Python und GitHub

Mit seiner benutzerfreundlichen und umfangreichen Bibliotheksunterstützung erleichtert Python die Interaktion mit BigQuery und automatisiert den gesamten Backup-Prozess.

Nun können Sie mit Python und GitHub, einer führenden Plattform für das Hosting und die Versionskontrolle von Code, Ihre Skripte verwalten, Änderungen nachverfolgen - und sogar mit anderen zusammenarbeiten.

Damit das funktioniert, müssen Sie die vorhandenen Python-Bibliotheken und -Repositories nutzen, um Ihren Entwicklungsprozess zu optimieren:

- google-cloud-bigquery. Diese offizielle Python-Bibliothek stammt von Google Cloud und bietet Funktionen wie die Verwaltung von Datensätzen, Zeitplanung und Ausführung von Abfragen.

Hier ist ein Beispiel für die Verwendung von Python zur Durchführung einer Abfrage

from google.cloud import bigquery

client = bigquery.Client()

# Führen Sie eine Abfrage durch.

QUERY = (

'SELECT name FROM `bigquery-public-data.usa_names.usa_1910_2013` '

'WHERE state = "TX" '

' LIMIT 100')

query_job = client.query(QUERY) # API-Anfrage

rows = query_job.result() # Wartet auf das Ende der Abfrage

for row in rows:

print(row.name)- google-cloud-storage. Mit dieser Bibliothek können Sie die Speicherung Ihrer Backups in der Google Cloud bequem automatisieren.

- pandas-gbq. Diese Bibliothek überbrückt die Lücke zwischen BigQuery und Pandas. Sie vereinfacht das Abrufen von Ergebnissen aus BigQuery-Tabellen mit SQL-ähnlichen Abfragen.

Beispiele dafür, was Sie mit der Bibliothek pandas-gbq tun können:

Durchführen einer Abfrage:

importieren Sie pandas_gbqErgebnis_dataframe = pandas_gbq.read_gbq("SELECT Spalte FROM Datensatz.table WHERE value = 'something'")

Ein Datenframe hochladen:

import pandas_gbqpandas_gbq.to_gbq(dataframe, "dataset.table")

Außerdem ist die Einhaltung einiger standardmäßiger Best Practices entscheidend, wenn Sie Python und GitHub zur Erstellung von BigQuery-Backups verwenden.

- Überwachen Sie Ihre Sicherungsaufträge. Implementieren Sie eine Fehlerbehandlung und Protokollierung in Ihre Skripte, um ein Warnsystem auszulösen, das Sie über mögliche Probleme beim Backup-Prozess informiert.

- Modularisieren Sie Ihre Python-Skripte. Modularisierung ist einfach eine Möglichkeit, Programme zu organisieren, wenn sie komplizierter werden. In diesem Fall sollten Sie Ihre Backup-Funktionen in wiederverwendbare Modelle aufteilen, damit sie leichter zu verwalten und zu pflegen sind, wenn sie wachsen.

- Verwenden Sie Konfigurationsdateien. Sie werden auch als "Konfigurationsdateien" bezeichnet und dienen dazu, Schlüssel-Wert-Paare eines Python-Codes zu speichern. Wenn Sie beispielsweise BigQuery-Backups durchführen, können Sie eine Konfigurationsdatei verwenden, um Projekt-IDs, Datensatznamen und Backup-Speicherorte zu speichern. Dies ermöglicht eine einfache Änderung, ohne den Code zu manipulieren.

Verwendung der Befehlszeile und des Google Cloud SDK

Die Befehlszeile (oder gCLI) ist eine Reihe von Tools, die zur Verwaltung von Anwendungen und Ressourcen verwendet werden, die in der Google Cloud gehostet werden. Zu diesen Tools gehören die Befehlszeilen-Tools gcloud, gsutil und bq. Sie können zum Beispiel alle Backup-Aufgaben über die Befehlszeile planen und automatisieren.

Auf der anderen Seite erleichtert das Google Cloud SDK die Entwicklung und Interaktion mit der Google Cloud API unter Verwendung Ihrer bevorzugten Programmiersprache.

Kombinieren Sie beides, und Sie können Ihre BigQuery-Backups bequem verwalten.

Wie Sie Ihr Google Cloud SDK einrichten.

- Weiter zu Cloud SDK - Bibliotheken und Befehlszeilen-Tools | Google Cloud.

- Laden Sie das Installationspaket Ihres jeweiligen Rechners (Windows, macOS, Ubuntu und Linux) herunter und folgen Sie den Anweisungen auf der Seite.

- Installieren Sie das Google Cloud SDK mit Hilfe von './google-cloud-sdk/install.sh' und folgen Sie den notwendigen Aufforderungen.

- Authentifizieren Sie Ihr Konto, um BigQuery-Ressourcen mit Hilfe der 'gcloud auth login' Befehlszeile zu aktivieren.

Nun, da Ihr Google Cloud SDK eingerichtet ist, müssen Sie als Nächstes die Befehlszeile verwenden, um verschiedene Sicherungsfunktionen auszuführen.

Erstellen von Backups

Um ein BigQuery-Backup mit der '[bq cp]'-Befehlszeile zu erstellen, kopieren Sie einfach die Tabelle von einem Speicherort zu einem anderen. Die Speicherorte können sich über verschiedene Projekte, verschiedene Datensätze oder sogar innerhalb desselben Datensatzes befinden.

bq cp [projekt_id]:[dataset].[tabelle] [projekt_id]:[backup_dataset].[backup_table]

Wobei Ihre;

- '[projekt_id]' Ihre Google Cloud ID ist.

- '[dataset]' enthält die Tabelle, die Sie sichern möchten.

- '[Tabelle]' enthält den Namen der Tabelle, die Sie sichern möchten.

- '[backup_dataset]' ist das Dataset, in dem Sie die Sicherung speichern möchten.

- '[backup_table]' ist der Name der Sicherungstabelle.

Daten exportieren

Sie verwenden die '[bq extract]' Befehlszeile, um Daten aus BigQuery in Google Cloud Storage oder externe Speichersysteme zu exportieren. Diese Befehlszeile ermöglicht auch den Datenexport in JSON, CSV, Avro und Parquet.

bq extract --destination_format=[format] [project_id]:[dataset].[table] gs://[bucket]/[path]

Ersetzen Sie hier;

- '[format]' mit Ihrem gewünschten Exportformat.

- '[Bucket]' mit dem Namen Ihres Google Cloud Storage Buckets.

- '[Pfad]' mit dem Pfad, in dem Sie die exportierten Daten speichern möchten.

Zum Beispiel:

bq extract --destination_format CSV 'mydataset.mytable' gs://mybucket/mydata.csv

Backups verwalten

Um Ihre BigQuery-Backups zu verwalten, verwenden Sie den Befehl '[bq ls]', um alle Backups [oder Tabellen] in einem bestimmten Dataset aufzulisten - oder '[bq rm]', um eine Tabelle zu löschen.

bq ls mydatasetbq rm 'mydataset.mytable'

Einschränkungen der BigQuery-Backup-Optionen

Begrenzte Point-in-Time-Wiederherstellungsoption

Angenommen, Sie haben einen wichtigen Datensatz in BigQuery, der häufig aktualisiert und transformiert wird. Eines Tages wird der Datensatz aufgrund eines Datenbeschädigungsproblems ungenau.

Da BigQuery keine Point-in-Time-Wiederherstellung bietet, können Sie den Datensatz nicht einfach in den Zustand vor dem Auftreten der Beschädigung zurückversetzen. Ohne automatisierte Backups müssen Sie sich möglicherweise auf manuelle Exporte oder Snapshots verlassen, die Sie zuvor erstellt haben, was zeitaufwändig und möglicherweise veraltet sein kann.

Komplexer Import- und Exportprozess

Angenommen, Sie haben einen großen Datensatz in BigQuery und möchten ein Backup in einem externen Speichersystem wie Google Cloud Storage (GCS) erstellen. BigQuery ermöglicht zwar den Export von Daten in Formaten wie Avro, Parquet oder CSV, aber der Export großer Datensätze kann komplex und ressourcenintensiv sein.

Der Export von mehreren Terabytes an Daten nach GCS kann beispielsweise erhebliche Zeit und Netzwerkressourcen erfordern, was zu zusätzlichen Kosten und potenziellen Störungen des laufenden Betriebs führt.

Schwache Aufbewahrungspolitik für Backups

Standardmäßig bewahrt BigQuery gelöschte Tabellen oder Datensätze 30 Tage lang im "Papierkorb" auf, bevor sie endgültig gelöscht werden. Dies bietet zwar einen gewissen Schutz gegen versehentliches Löschen, aber Sie können diese Aufbewahrungsfrist nicht verlängern oder anpassen.

Ressourcenintensive Skripterstellung und Konfiguration

Die Verwaltung von Skripten und benutzerdefinierten Konfigurationen kann komplex sein, insbesondere wenn die Umgebung skaliert. Die Verwaltung von Skripten kann für einen Dienst wie BigQuery entmutigend und zeitintensiv sein, ganz zu schweigen davon, wenn Sie für die Verwaltung mehrerer Cloud-Dienste verantwortlich sind.

BigQuery Backup & Recovery: Das Fazit

Google BigQuery ist zweifellos ein leistungsstarkes Tool für datengesteuerte Unternehmen. Seine blitzschnellen SQL-Abfragen, die integrierten Funktionen für maschinelles Lernen und die skalierbare Infrastruktur machen es zu einer zuverlässigen Lösung - insbesondere für die Verarbeitung großer Datenmengen. Allerdings müssen die wertvollen Schemata, Datensätze und Tabellen in BigQuery geschützt werden, um das Risiko von Datenverlusten oder Systemausfällen zu mindern. Hier kommt HYCU ins Spiel, um den Tag zu retten.

Mit HYCU Protégé erhalten Sie 1-Klick-Backups und granulare Wiederherstellung für Ihre BigQuery-Daten. Diese automatisierte Sicherung läuft rund um die Uhr und 365 Tage die Woche und bietet Ihnen die Gewissheit, dass Ihre BigQuery-Daten bei Bedarf verfügbar sind.

Brauchen Sie ein Cloud-natives Backup & Restore für Google BigQuery?

Erhalten Sie die neuesten Erkenntnisse und Updates

By submitting, I agree to the HYCU Abonnementvertrag , Terms of Usage , and Datenschutzbestimmungen .